Генеративний штучний інтелект і великі мовні моделі (LLM) — це нова революція штучного інтелекту, яка надає світові можливості, про які ми могли лише мріяти менше двох років тому. На відміну від попередніх етапів, таких як Deep Learning, у нинішній революції ШІ все відбувається швидше, ніж будь-коли раніше.

Багатьом здається, що потяг ось-ось відправиться зі станції, а раз ми говоримо про швидкісні потяги – кожен день має значення. Отже, як дістатися до станції, щоб вчасно сісти на цей потяг, і, що важливіше, як дізнатися, що ви сідаєте на потяг, який найбільше підходить для вашої програми?

Очікувано, більшість операцій з розробки програмного забезпечення інтегруватимуть Generative AI у свої програми, тому давайте розглянемо деякі ключові моменти, щоб переконатися, що ви на правильному шляху та рухаєтесь у правильному напрямку.

Існуючі рішення

Ось три поширені рішення для підключення до великих мовних моделей (LLM):

- Специфіка компанії: одним із найпростіших рішень для реалізації є пряме підключення до існуючих моделей, які пропонуються на провідних платформах розробників, таких як OpenAI, Google, Mistral, Anthropic , Cohere , DeepSeek та інші.

- Агрегатори моделей: певні постачальники хмарних технологій пропонують підтримку ШІ з прямим підключенням до кількох моделей із керованих служб, таких як Amazon Bedrock і Microsoft Azure . Перевагою цього варіанту є отримання доступу до кількох настроюваних моделей за допомогою одного постачальника.

- Відкритий вихідний код: у мережі є кілька сховищ моделей (найпопулярнішим є Hugging Face ), які можна використовувати для комерційних програм. Ці моделі пропонують високий рівень гнучкості з точки зору тонкого налаштування моделі відповідно до ваших вимог. Це також єдиний варіант, який працює для програм, що містять конфіденційні дані.

Пам’ятайте, що окрім запуску моделей, вам також знадобиться місце для зберігання моделей і спосіб керування ними за допомогою таких рішень, як JFrog Artifactory для MLOps .

MaaS чи Self-Hosted?

Найперше питання, коли ви думаєте про початок проекту Generative AI, можливо, де знаходиться модель? Епоха глибокого навчання навчила більшість із нас використовувати власні моделі, які зазвичай поширюються в хмарних сервісах. GenAI надає нам нову опцію – Model-as-a-Service (MaaS), яка швидко стала основною опцією в умах багатьох людей завдяки OpenAI. Отже, якою послугою варто скористатися?

Давайте розберемо це питання

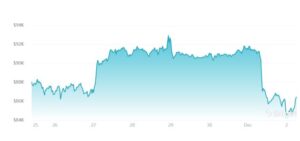

Витрати

Найважливішим зазвичай є те, скільки нам це коштуватиме? Порівняння витрат на моделі MaaS і самостійно розміщених моделей не є тривіальним, оскільки MaaS зазвичай оплачується за допомогою токенів, а витрати на саморозміщення визначаються обчислювальною потужністю та використанням. Отже, насправді все зводиться до питання про прогнозоване використання послуги. Чим більше використання, тим більша ймовірність того, що ви захочете використовувати режим самостійного розміщення.

Безпека

У деяких випадках надсилання запитів через Інтернет до віддаленої служби може становити загрозу безпеці або порушення політики. Якщо це так, то MaaS може бути не правильним варіантом для вас.

З іншого боку, варто зазначити, що під час використання моделей з відкритим кодом необхідно враховувати безпеку, навіть якщо вони надходять із добре відомих сайтів, таких як Hugging Face або Kaggle. Ці сайти, по суті, є службами хостингу моделей, і хоча вони пропонують певний рівень безпеки, ви повинні бути обережними, використовуючи моделі з відкритим кодом у своїй власній інфраструктурі, оскільки ці служби також можуть запроваджувати шкідливі пакети .

Мережа

Одним із найбільших недоліків використання MaaS є мережа. Кожен запит має надсилатися на інший сервер, швидше за все, в іншому регіоні, і це спричиняє значне збільшення затримки. Крім того, певні платформи можуть обмежувати кількість запитів, які ви можете зробити за годину, що може стати проблемою, якщо ви розробляєте основний продукт, який передбачає значну кількість запитів. Знову ж таки, що більше використання, то менша ймовірність MaaS для вас.

Вибір правильної моделі

Не всі LLM створені рівними, і це з дуже поважних причин. Кожна модель має свої переваги і недоліки. Пошук найкращої моделі для вашого завдання потребує певного розгляду щодо розміру моделі та підтримки мови.

Розмір

Так, розмір має значення. Чим більше модель, тим краще вона справляється з не надто тривіальними завданнями. Але більші моделі також є повільнішими та дорожчими, якщо платити токенами або розміром машин, необхідних для їх роботи. Завжди намагайтеся знайти мінімальний розмір, необхідний для ваших цілей, інакше використання надмірно великих моделей є надійним способом спалити гроші та витратити ваш бюджет.

Мова

Якщо ваше завдання передбачає лише довільний текст англійською мовою, ви можете пропустити цей розділ. Але якщо вам потрібно більше, можливо, доведеться переглянути, які моделі використовувати. Деякі моделі налаштовані для виведення коду, тоді як інші зосереджені на конкретних мовах. Існують магістратури, призначені в основному для англійської мови, які також здатні вивчати додаткові мови. Проблема з цими моделями полягає в тому, що продуктивність може бути знижена, коли додається більше мов. У таких випадках краще використовувати LLM, розроблені спеціально для багатомовних програм . Вибір моделі, яка найкраще підходить для вашої цільової мови, може мати величезне значення.

Швидкий темп

Це важко зрозуміти, але NLP Generative AI-for-the-masses приблизно 18 місяців. Те, що починалося як єдиний експериментальний мовний продукт наприкінці листопада 2022 року, розвинулося до понад 15 000 моделей до середини 2023 року, і ми тільки починаємо. Моделі, які були найсучаснішими лише кілька місяців тому, були перевершені новими альтернативами – від Llama 3, яка піднімає планку моделей з відкритим кодом, до Claude 3, яка показує кращі показники, ніж GPT-4 – і навіть з’являються більш перспективні технології. коли ви читаєте ці самі слова. Щоб йти в ногу з найновішими моделями, розробники штучного інтелекту повинні швидше, ніж будь-коли, прискорювати темпи впровадження та цикли зміни технологій.

Це означає постійну переоцінку продуктивності вашої поточної моделі порівняно з новими варіаціями та перенавчання існуючих програм за допомогою нових моделей для покращення продуктивності, навіть якщо поточна версія повністю функціональна. Пам’ятайте, що навіть якщо ваша ефективність може відповідати очікуванням, ваші конкуренти можуть застосовувати новіші моделі зі значно кращими результатами.

Суть

LLM — це те, що ми маємо зараз, найближче до справжньої магії, і, як би це не було захоплююче, вибір неправильної моделі може призвести до втрати багато часу та грошей, тоді як вибір правильної моделі може змінити успіх і поразку. Ми сподіваємося, що ці відомості будуть корисними та допоможуть вам стрибнути вперед із власними програмами ШІ за допомогою рішень JFrog MLOps . Дізнатись більше про JFrog MLOps можна на сайті виробника – Jfrog. Також можна звернутися по допомогу до партнера розробника – компанії Ідеалсофт, яка організує для вас он-лайн зустріч з розробниками.

Долучайтесь!

+ Поки нема коментарів

Додати перший